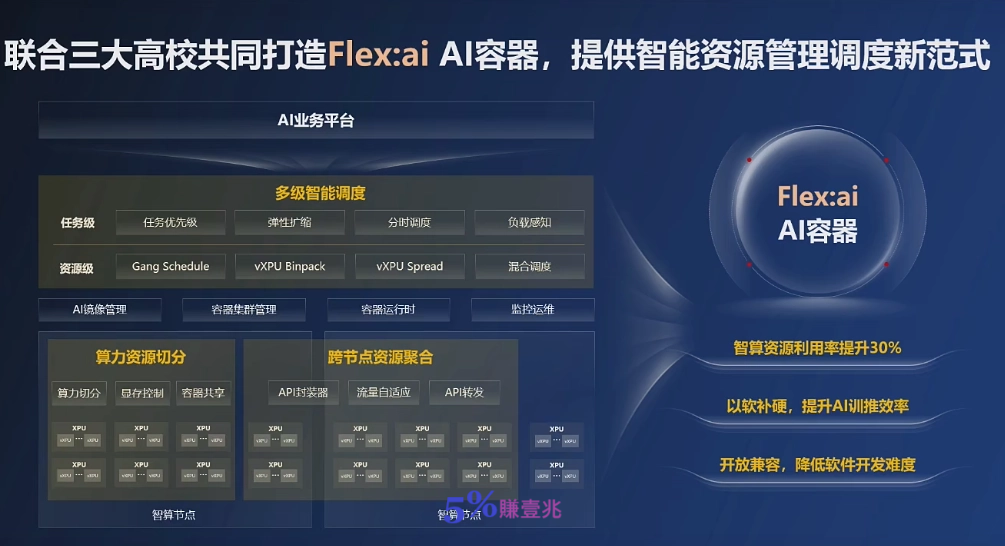

IT之家11 月21 日消息,在今日的AI 容器應用落地與發展論壇上,華為發布Flex:ai AI 容器軟體,透過算力切分技術,將單張GPU / NPU 算力卡切分為多份虛擬算力單元,切分粒度精準至10%,實現了單張GPU / NPU 算力卡切分為多份虛擬算力單元,切分粒度精準至10%,實現了單張空間卡同時承載多個集電空間組數

Flex:ai 是一款基於Kubernetes(開源容器編排平台)構建的XPU(各種類型處理器)池化與調度軟體,主要是透過對GPU、NPU 等智慧算力資源的精細化管理與智慧調度,實現對AI 工作負載與算力資源的「精準匹配」。

相較於英偉達旗下Run:ai 公司的核心技術,華為認為Flex:ai 具備兩大獨特優勢:

一是虛擬化。除了在本地虛擬化技術中實現算力單元的按需切分,Flex:ai 獨有的「拉遠虛擬化」技術,可以不做複雜的分散式任務設置,將叢集內各節點的空閒XPU 算力聚合形成「共享算力池」。

二是智能調度。 Flex:ai 的智慧資源與任務調度技術,可自動感知叢集負載與資源狀態,結合AI 工作負載的優先權、算力需求等多維參數,對本地及遠端的虛擬化GPU、NPU 資源進行全域最優調度,滿足不同AI 工作負載對資源的需求。

IT之家從發布會獲悉,Flex:ai 將在發布後同步開源在魔擎社群中。