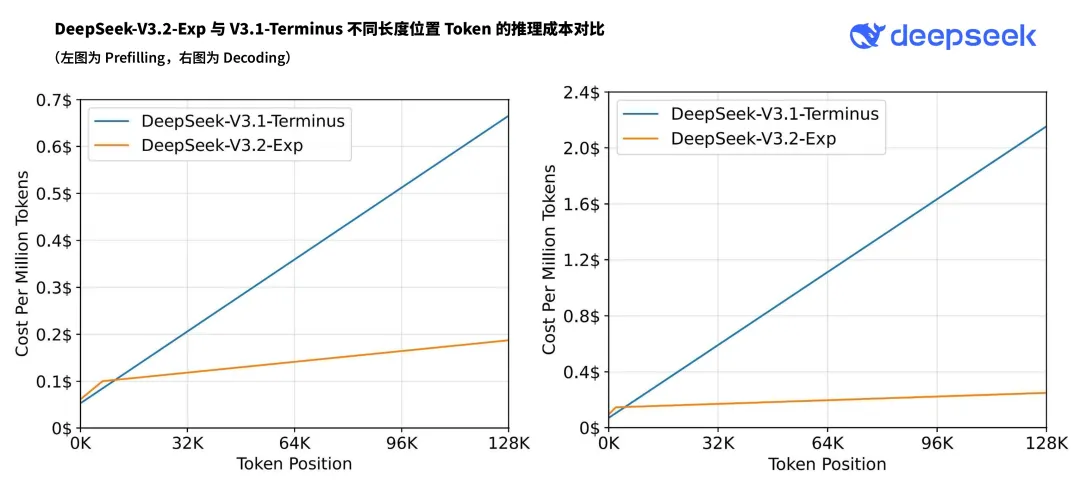

DeepSeek-V3.2-Exp 發布,訓練推理提效,API 同步降價今天,我們正式發布DeepSeek-V3.2-Exp 模型,這是一個實驗性(Experimental)的版本。作為邁向新一代架構的中間步驟,V3.2-Exp 在V3.1-Terminus 的基礎上引入了DeepSeek Sparse Attention(一種稀疏注意力機制),針對長文本的訓練和推理效率進行了探索性的優化和驗證。 目前,官方App、網頁端、小程式均已同步更新為DeepSeek-V3.2-Exp,同時API 大幅降價,歡迎廣大使用者體驗測試並向我們回饋意見。 DeepSeek Sparse Attention(DSA)稀疏注意力DeepSeek Sparse Attention(DSA)首次實現了細粒度稀疏注意力機制,在幾乎不影響模型輸出效果的前提下,實現了長文本訓練和推理效率的大幅提升。  為了嚴謹地評估引入稀疏注意力帶來的影響,我們特意把DeepSeek-V3.2-Exp 的訓練設定與V3.1-Terminus 進行了嚴格的對齊。在各領域的公開評測集上,DeepSeek-V3.2-Exp 的表現與V3.1-Terminus 基本持平。 論文連結& 模型DeepSeek-V3.2-Exp 模型現已在Huggingface 與魔搭開源:

TileLang & CUDA 算子在新模型的研究過程中,需要設計和實作許多新的GPU 算子。我們使用高階語言TileLang 進行快速原型開發,以支援更深入的探索。在最後階段,以TileLang 作為精確度基線,逐步使用底層語言實現更有效率的版本。因此,本次開源的主要算符包含TileLang 與CUDA 兩種版本。我們建議社群在進行研究性實驗時,使用基於TileLang 的版本以方便調試和快速迭代。 API由於新模型服務成本的大幅降低,官方API 價格也隨之下調,新價格即刻生效。  在新的價格政策下,開發者呼叫DeepSeek API 的成本將降低50% 以上。 目前API 的模型版本為DeepSeek-V3.2-Exp,存取方式保持不變。歡迎用戶使用DeepSeek 官方的API 服務。 用戶場景比較作為一個實驗性的版本,DeepSeek-V3.2-Exp 雖然已經在公開評測集上得到了有效性驗證,但仍然需要在用戶的真實使用場景中進行範圍更廣、規模更大的測試,以排除在某些場景下效果欠佳的可能。為方便使用者進行比較測試,我們為DeepSeek-V3.1-Terminus 暫時保留了額外的API 存取介面。使用者只需修改 誠摯希望廣大用戶在對比測試中為我們提供寶貴的回饋意見,回饋連結:https://feedback.deepseek.com/dsa  |